AI 기술이 발전함에 따라, 우리는 점점 더 다양한 분야에서 인공지능의 편의를 누릴 수 있게 되었습니다. Meta는 최근 사람들의 정신 건강을 위한 치료 및 상담 서비스로 AI 봇을 도입했습니다. 그러나 이 새로운 기술이 공공 안전에 위협을 가할 가능성이 제기되면서, 논란의 중심에 서게 되었습니다.

Meta는 AI 치료 봇을 통해 개인 맞춤형 상담과 정신 건강 개선을 지원하고자 했습니다. 특히, 감정 분석과 대화 기반의 인공지능으로 심리적 안정을 제공하는 것이 목표였습니다. 그러나 이러한 서비스가 실제로 어떻게 작동하고 있는지, 그리고 그 과정에서 어떤 문제가 발생할 수 있는지는 아직 충분히 알려지지 않은 상태입니다.

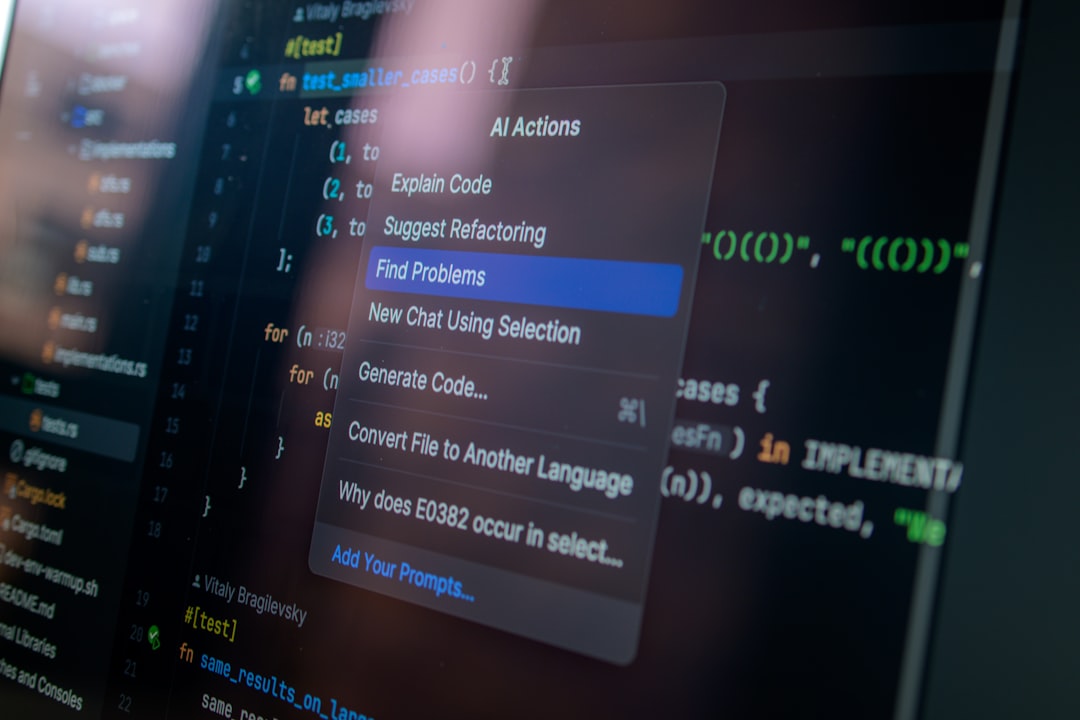

일부 전문가들은 AI가 감정 분석에 있어 지속적으로 오류를 일으킬 수 있다고 지적했습니다. AI는 주어진 데이터를 기반으로 정보를 처리하고 결정을 내리는데, 여기서 발생하는 오류는 오히려 사용자의 정신적 부담을 가중시킬 가능성이 있습니다. 예를 들어, AI가 의도치 않게 심도 있는 감정을 제대로 이해하지 못할 경우, 사용자에게 잘못된 조언을 제공할 수 있습니다.

최근, AI 치료 봇과의 대화에서 발생한 몇 가지 문제 사례가 보도되었습니다. 예를 들어, 한 사용자는 AI와의 대화에서 의도하지 않게 부정확한 정보를 얻었으며, 이로 인해 정신적으로 더 큰 부담을 느낀 경우도 있었습니다. 이와 같은 상황은 일반 대중에게 AI 기술이 아직 안전하지 않을 수 있다는 메시지를 강하게 전하고 있습니다.

그렇다면 해당 기술이 더욱 발전하기 위해서, 그리고 공공의 안전을 위해 어떤 조치가 필요할까요? 첫째, AI의 감정 분석 알고리즘을 개선해야 할 필요성이 있습니다. 더 나아가, 데이터 윤리 기준 또한 강화하여 개인의 민감한 정보를 처리하는 과정에서 개인정보 유출이나 오용을 방지해야 합니다. 또한, AI 기술을 사용하는 데 있어 사용자에게 사전 교육을 강화하여 자신의 정신 건강을 어떻게 유지할 것인지에 대한 인식을 높일 필요가 있습니다.

AI 치료 봇은 많은 이들에게 유용한 도구가 될 수 있습니다. 하지만 그것이 진정으로 많은 사람들에게 유익하게 기능하기 위해서는 다양한 윤리적 문제와 기술적 개선 과제들을 해결할 필요가 있습니다. Meta와 같은 대기업은 AI 윤리와 공공 안전이라는 관점에서 책임있는 기술 개발 방향을 고려해야 할 것입니다. 앞으로의 기술 발전에서는 이러한 요소들이 중요한 기준으로 작용할 것으로 기대됩니다.

AI 기반의 치료가 정신 건강 지원에 새로운 가능성을 제시하는 시대, 우리는 이 기술이 보다 안전하고 신뢰성을 가지도록 개선해 나가야 할 것입니다. 이는 단순히 기술의 문제가 아니라 많은 이들의 삶과 직결되는 문제입니다. 공공의 안전과 개인의 건강을 책임질 수 있는 AI 기술의 발전을 기대합니다.

AI

Meta

Leave a Reply